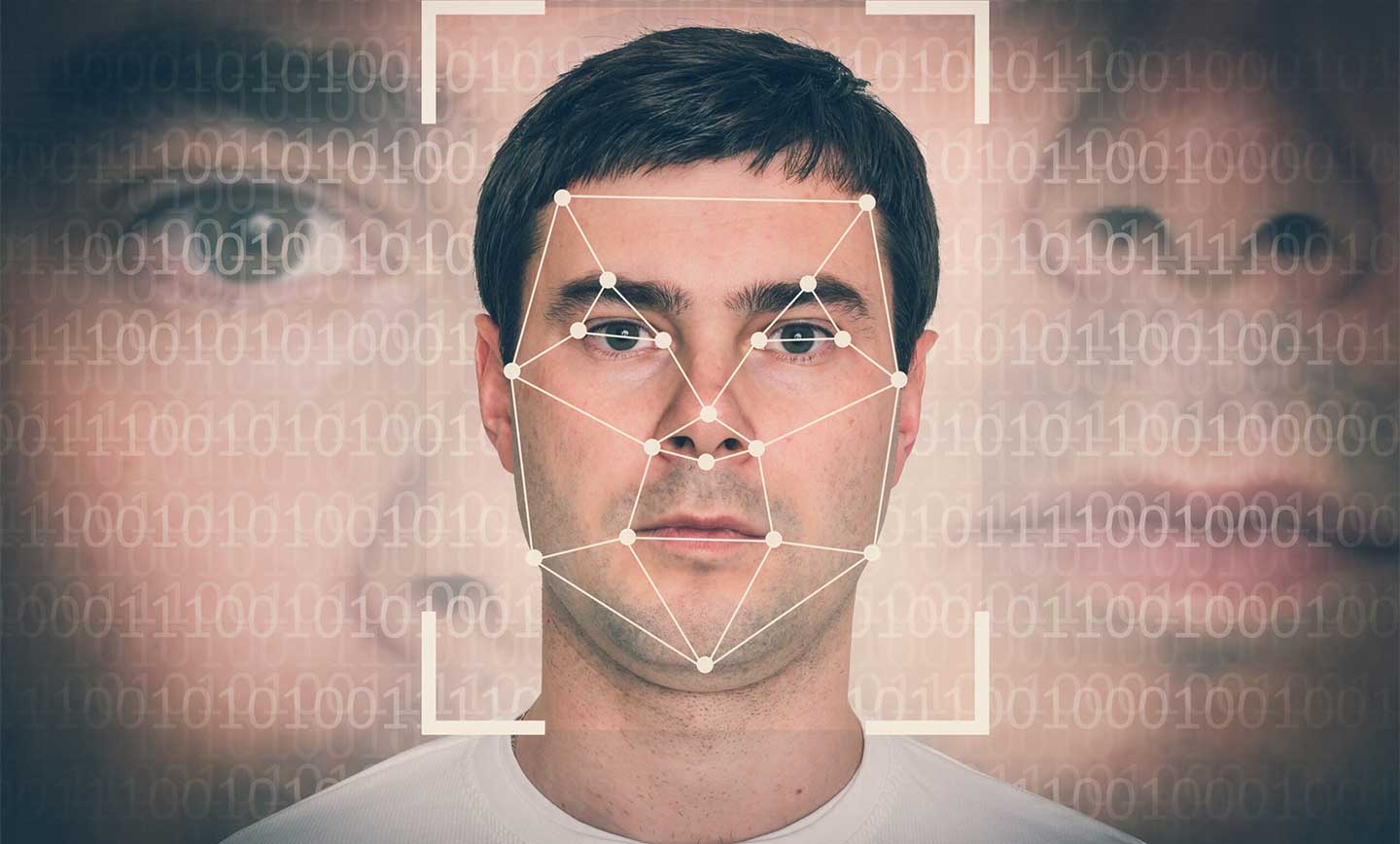

موسسه فناوری ماساچوست (MIT) از تکنیکی رونمایی کرده که با ایجاد بههمریختگی خاصی که به چشم انسان نمیآید، موجب میشود هوش مصنوعی نتواند چهره را درست تشخیص دهد. در ادامه این خبر با مایکت همراه باشید.

Dall-E و Stable Diffusion فقط نقطه آغازی بر شروع یک تکنولوژی بودند. سیستمهای مولد مبتنی بر هوش مصنوعی همواره در حال بیشتر شدن هستند و شرکتها در تلاش هستند که ابزار متفاوتی را نسبت به رقبای خود ارائه دهند. چتباتها هم در سراسر اینترنت حالا قابلیت این را دارند که تصاویر را دستکاری کنند و دست به خلق عکسهای تازهای بزنند. در این میان میتوان گفت Shutterstock و Adobe سردمدار این تغییرات هستند. اما این قابلیتهای مبتنی بر هوش مصنوعی ممکن است با سوء استفاده افراد مجرم هم همراه شوند. مثلا احتمال دارد به صورت غیرمجاز تصاویر چهره کاربران دستکاری شده و به طور کلی یک سرقت از تصاویر و کارهای هنری موجود فضای آنلاین صورت بگیرد. تکنیک واترمارک کردن (Watermark) میتواند باعث کاهش مورد دوم و استفاده غیرمجاز دیگران از تصاویر شما شود. همچنین در خصوص مورد اول هم حالا PhotoGuard از سوی آزمایشگاه علوم کامپیوتر و هوش مصنوعی MIT یا همان MIT CSAIL توسعه پیدا کرده تا مانع از دستکاری عکسهای چهره شود.

- کوالکام و متا در سال 2024 هوش مصنوعی بدون نیاز به اینترنت را روی موبایل میآورند

- هوش مصنوعی و مشکل حفظ حریم شخصی

PhotoGuard دست به ایجاد تغییر در پیکسلهای انتخاب شده عکس میزند تا قابلیت هوش مصنوعی را برای درک درست تصویر از بین ببرد. این تغییرات که تیم سازنده از آن به عنوان «بههمریختگی» یاد میکند، توسط چشم انسان قابل تشخیص نیستند، اما هوش مصنوعی به راحتی آنها را تشخیص میدهد. در روش حمله رمزگزاری (Encoder) در تصویر هدف باعث تغییر در الگوریتم و اطلاعات مخفی عکس میشود و کاری میکند که هوش مصنوعی قادر نباشد درک کند که در حال تماشای چه چیزی است. آن چه در عکس دستخوش تغییر میشود در واقع اطلاعات پیچیده محاسباتی است که به موقعیت و رنگ هر پیکسل در تصویر مربوط میشود.

در روش پیشرفتهتر و محاسبهمحورتر ما شاهد عملیات گسترش (Diffusion) هستیم. اما این روش چیست؟ در این روش تصویر در چشم هوش مصنوعی به شکلی دیگر دیده میشود. در نتیجه هوش مصنوعی تصویر هدفی را تشخیص میدهد که دچار بههمریختگی شده و شکل و شمایل دیگری دارد و در نتیجه نمیتواند تغییرات صحیحی را به وجود آورد. در واقع هر تغییری که بخواهد توسط هوش مصنوعی روی تصویر محافظت شده پیادهسازی شود، روی عکسی اعمال میشود که جعلی است و در نتیجه حاصل کار هم حالت واقعگرایانه نخواهد داشت.

هادی سلمان، دانشجوی دکترا در دانشگاه MIT و نویسنده اصلی مقاله، به رسانه Engadget گفت: «در روش Encoder مدل هوش مصنوعی تصور میکند ورودی (که قرار است ویرایش شود) یک تصویر دیگر است (مثلا یک عکس خاکستری رنگ). در صورتی که روش Diffusion هوش مصنوعی تغییرات را روی یک تصویر هدف متفاوت اعمال میکند (که میتواند یک عکس اتفاقی یا خاکستری باشد).» البته این تکنیک را میتوان دور زد و میشود به روش مهندسی معکوس تصاویری که با نویز دیجیتالی یا مواردی از این قبیل محافظت شدهاند را به حالت اصلی بازگرداند.

سلمان در ادامه گفت: «رویکرد مشترک توسعهدهندگان هوش مصنوعی، پلتفرمهای شبکه اجتماعی و سیاستگذاران میتواند به ایجاد یک سازوکار دفاعی قدرتمند در مقابل دستکاری غیرمجاز تصاویر کمک کند. کار روی این موضوع مهم در حال حاضر از اهمیت بالایی برخوردار است. با این که من از مشارکت در این پروژه خوشحال هستم، باید بگوییم که باید خیلی بیشتر روی آن کار کنیم تا بتوانیم از نظر امنیتی یک ارائه خوب را داشته باشیم. شرکتهایی که در حوزه توسعه هوش مصنوعی کار میکنند، باید روی محافظت محتوا دربرابر تهدیدات احتمالی که این ابزارهای هوش مصنوعی باعثشان میشوند، سرمایهگذاری کنند.»

منبع: engadget